На конференции NeurlPS2020 американские разработчики представили алгоритм, способный восстановить звук по видео.

Нейросеть просматривала видеоролик с игрой на фортепиано в беззвучном режиме. Алгоритму нейросети удалось воспроизвести звук из видео.

Разработка принадлежит команде Вашингтонского университета. Создание алгоритма происходило под руководством Эли Шлицермана. В 2018 году под этим же руководством был создан другой алгоритм. Группа разработчиков научила нейросеть слушать музыку и предсказывать движения рук музыкантов по аудиозаписи.

Для создания нового алгоритма учёным нужно было учесть несколько параметров:

• Особенности музыкального инструмента;

• Музыкальная композиция видео;

• Движения рук музыканта во время игры.

Для человека этих данных должно быть достаточно, чтобы суметь восстановить звуки инструмента максимально точно. Однако в случае с алгоритмом всё не так просто.

В ходе работы над алгоритмом разработчики из университета Вашингтона учли не только фактическое нажатие клавиш. Они уделили внимание продолжительности нажатия.

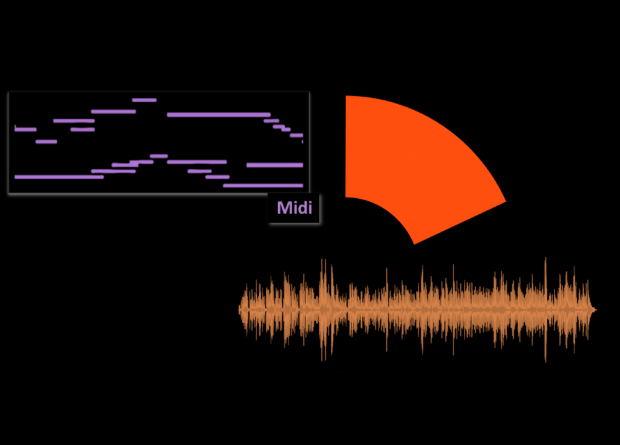

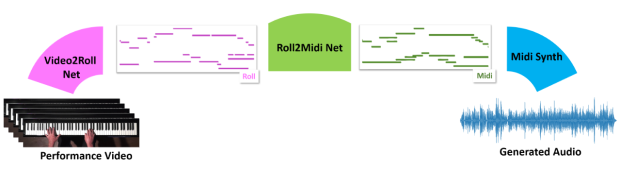

Алгоритм нейросети строится в три этапа. На первом этапе Video2Roll (так назвали алгоритм) получает по 5 кадров из видеозаписи и запоминает последовательность нажатия клавиш.

Затем полученные данные преобразуются в нужный формат и «отфильтровывают». Из полученных данных составляется обучающая выборка.

Заключительный этап – превращение данных в звук. Делается это с помощью нескольких программ: FluidSynth и PerfNet. Исследователи отмечают, что воспроизводимая мелодия очень похожа на оригинальное звучание, как в видеозаписи.

Проверка проводилась с помощью программы Sound Hound. В результате проверки эффективности алгоритма авторы проекта отметили, что звук, воспроизведённый нейросетевым синтезатором PerfNet, получается более «эмоциональным» и живым.